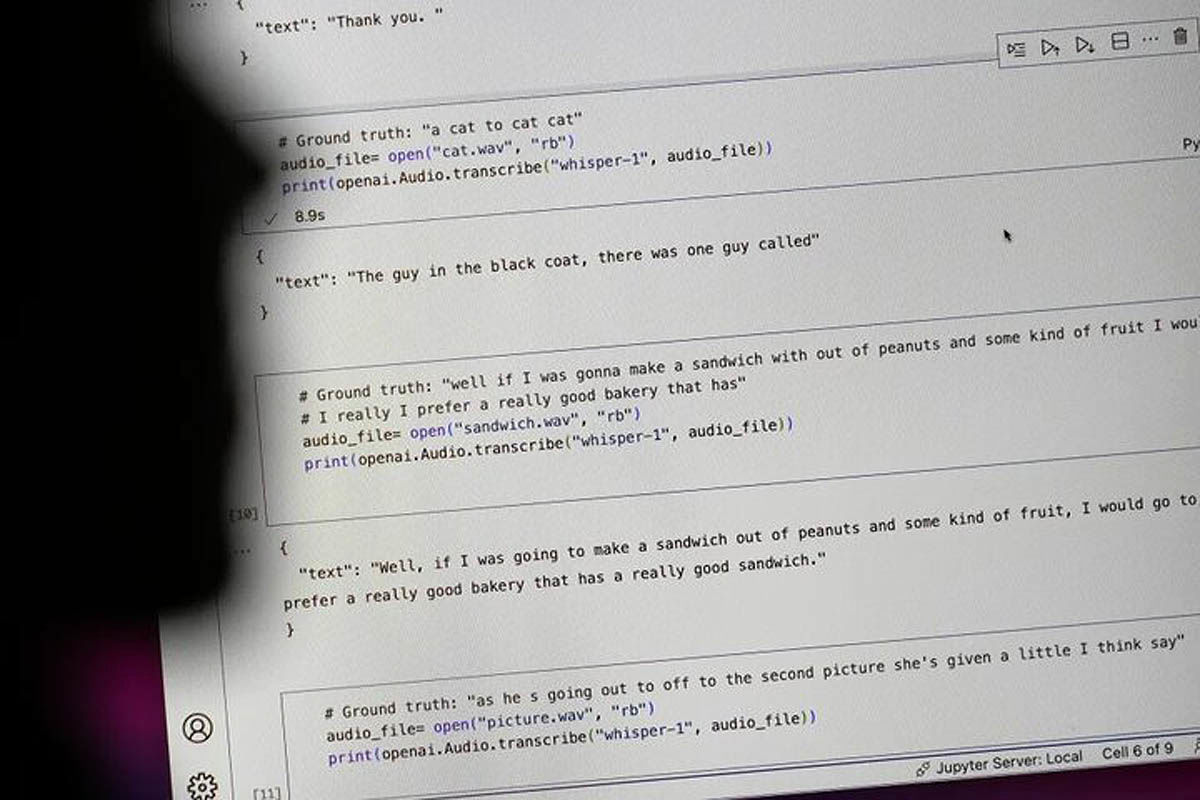

به گفته مهندسان نرمافزار، توسعهدهندگان و محققان آکادمیک ممکن است این ابزار بخشی از متن یا حتی جملاتی کامل را خودش بنویسد. این کارشناسان معتقدند برخی از متنهای اختراعی این ابزار ممکن است حاوی اظهارات نژادی، خشونتآمیز یا حتی درمانهای پزشکی خیالی باشد. به گفته آنها چنین جملاتی مشکلساز هستند، زیرا از این ابزار در چند صنعت در سراسر جهان برای تبدیل مصاحبهها، تولید متن در زمینه فناوریهای مصرفی محبوب و ساخت زیرنویس برای ویدئوها استفاده میشود.

نکته نگرانکنندهتر، عجله مراکز پزشکی برای استفاده از ابزارهای مبتنی بر ویسپر برای رونویسی مشاورههای بیماران با پزشکان است. حال آنکه اوپنایآی قبلا هشدار داده از این ابزار نباید در حوزههایی با ریسک زیاد استفاده شود. گستره کامل این مشکل را به سختی میتوان تعیین کرد، اما محققان و مهندسان اعلام کردهاند در فعالیتهایشان اغلب با توهمات ابداعی ویسپر روبهرو شدهاند. به عنوان مثال یک محقق دانشگاه میشیگان مشغول انجام تحقیقی از جلسات عمومی بود و در هر ۱۰ رونویسی کلیپ صوتی که او بررسی کرده بود ۸ مورد حاوی توهمات ویسپر بودند. پس از آن وی تلاش خود برای ارتقای این مدل هوش مصنوعی را آغاز کرد. یک مهندس یادگیری ماشینی نیز میگوید او بیش از ۱۰۰ ساعت نمونه رونویسی که ویسپر انجام داده بود را تحلیل و در حدود نیمی از آنها توهمات این هوش مصنوعی را مشاهده کرده است. محقق سومی نیز مدعی شده هنگام بررسی ۲۶ هزار متنی که با کمک ویسپر ابداع شده، تقریبا در هر یک از رونویسیها توهمات این ابزار را مشاهده کرده است. این چالش حتی در رونویسی از نمونههای کوتاه و با کیفیت صوتی نیز وجود دارد.